В пятницу утром компания Intel сообщила о разработке Core and Visual Computing Group, подразделения по подготовке разрывных графических микропроцессоров для игровых ПК, и ускорителей вычислений для суперкомпьютеров и разных многообещающих дополнений. Свежую компанию возглавит знаменитый эксперт Султан Кодури (Raja Koduri), поспевший потрудиться в ATI, Эпл и AMD Radeon Технолоджис Group. Сам факт того, что в Intel приняли решение прийти к образованию разрывных графических микропроцессоров в 3-й раз, говорит о том, что организация значительно меняет стратегию на нескольких рынках.

«Султан считается одним из наиболее квалифицированных, революционных и дорогих визионеров в сфере графических и системных архитектур в промышленности и ещё одним образцом того, как самые лучшие дарования подключаются к Intel,» — заявил Мурти Рендучинтала (Murthy Renduchintala), вице-президент компании Client and Internet of Things Business & Systems Architecture Group (CISA). «У нас есть завораживающие проекты по серьезному расширению наших вычисляемых и графических перспектив с применением нашего безграничного кошелька умной собственности. С Раджей во главе Core and Visual Computing Group мы добавим также в наш кошелек непревзойдённые возможности, продвинем нашу стратегию в сфере вычислений и графики и, потом, будем движущей силой революции обработки данных».

Султан Кодури

Intel возвращается на рынок разрывных GPU

Учитывая характер анонса, сложно ждать, что Intel откроет многообещающий план по подготовке графических и вычисляемых технологий, который будет реализовываться под управлением г-на Кодури. Все-таки, пресс-релиз Intel открывает ряд компонентов о характере грядущих решений компании.

Главной целью Раджи Кодури в Intel будет образование рода высокопроизводительных разрывных графических решений для разных дополнений. Данные решения будут находиться на унификации разных архитектур и умной собственности Intel, но конечные продукты будут применяться для обработки графики, суперкомпьютерных вычислений, синтетического разума и ряда иных многообещающих назначений.

Впрочем цель г-на Кодури представляется единственной, её выполнение обозначает значительный сдвиг в стратегии Intel по целому ряду назначений, поэтому есть резон вспомнить расклады Intel к подготовке GPU и суперкомпьютерным ускорителям.

Intel 740 и графические адаптеры ценой похода в кафе

Смотря на подрывной рост репутации графических адаптеров для игровых ПК в 1990-х гг. прошлого столетия, в Intel поняли, что такие микросхемы могут стать свежим рынком сбыта, поэтому компания должна выпустить свой графический микропроцессор. Так как у Intel не было своей команды создателей видеокарт, то для работы над планом Auburn организация приняла решение соединить старания с иными игроками рынка — Real3D (первоначально отделение Дженерал Electric, потом — Lockheed Мартин) и Chips and Технолоджис.

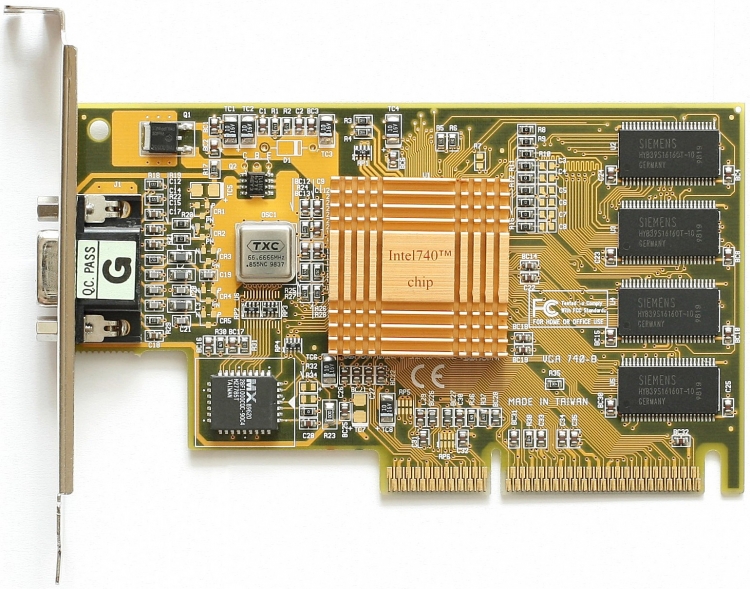

Видеокарта на основе Intel 740. Фото Wikipedia.org

Auburn родился в самом начале 1998 года под названием Intel 740, но его основной отличительной чертой стало применение новейшей по тем временам покрышки AGP. Теоретически AGP позволяла держать структуры в системной памяти, этим самым снижая условия к объёмера материнской платы на картинном адаптере и его себестоимость. На деле держать структуры в системной памяти было нерентабельно с позиции мощности, драйверы Intel 740 были весьма неидеальны, но конкуренция со стороны классических создателей видеокарт настолько серьёзной, что в Intel решили закончить реализации i740 весной 1999 года. Немного позднее Intel предприняла попытку выпустить ещё 1 разрывный графический микропроцессор (Intel 752), не сумела сделать его сколько-то глобальным.

Невезения i740 и i752 продемонстрировали Intel, что организация не в состоянии перенести конкуренции с ATI и Nvidiа на рынке графических адаптеров. Но имеющиеся тогда возможности полупроводникового великана в сфере интеграции, изготовления и реализаций сказали Intel, что она может формировать доступные встроенные графические решения для доступных ПК. Так что, в недрах Intel появилось на свет отделение под управлением Тома Пиаццы (Tom Piazza), которое занималось подготовкой графических микропроцессоров Graphics & Media Accelerator (GMA), чья стоимость для конечных клиентов была равна стоимости похода в кафе. Так как Intel жёстко урезала формирование собственных интегрированных GPU транзисторным расчетом, габаритами на кристалле и старыми техническими действиями изготовления, GMA имели достаточно непрезентабельные возможности и среднюю репутацию.

Схема Intel 740 на оперативной памяти

Через 3 года в Intel жалели о таком раскладе, однако до тех пор дешевая видео графика Intel стала очень распространенной среди желающих понизить себестоимость изготовителей ПК.

Intel Larrabee: x86 от игрового ПК до суперкомпьютера

Тянулось время, в самом начале 2000-х годов в области начали говорить о том, что GPU применяют для определённых вычислений совместного предназначения в суперкомпьютерах, получив превосходство от их «параллельности». Кроме GPU, на рынке являлись неоднородные (Niagara/Sun UltraSPARC T1) и одинаковые (Cell BE) многоядерные микропроцессоры, также нацеленные в т. ч. на суперкомпьютеры. Конечно, как GPU, так и многоядерные CPU представляли непосредственную опасность для Intel. Кроме этого, невзирая на то, что встроенные GPU Intel применялись в неограниченном количестве доступных ПК, рынок дорогостоящих разрывных GPU вырастал, равно как средняя цена графических карт. Так что, в 2005 году руководство Intel решило обновить работу над разрывными картинными микропроцессорами, однако при этом не стараться сделать лучше архитектуру GMA до значения разрывных GPU ATI и Nvidiа, но сделать что-то другое. Потом это стало планом Larrabee.

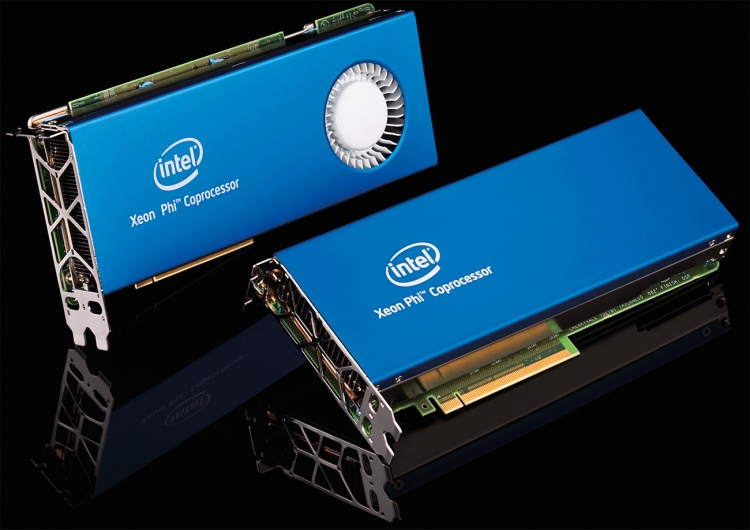

Intel Xeon Phi

Главные условия к проектируемой GPU-архитектуре были элементарны: множество вычисляемых ядер совместного предназначения на основе архитектуры x86, большая тактовая частота, предельное число операций с плавучей запятой за секунду (TFLOPS), минимум своеобразных для GPU блоков. Принимая во внимание условия и универсальной характер грядущего продукта, первоначально проект будет называться SMAC (Simple, Massive Array of Cores — простой большой массив ядер). В начальстве Intel полагали, что «эластичные» индукционные x86-ядра сумеют делать такие же цели, что и специальное аппаратное обеспечение в GPU с хорошей скоростью, их число позволит максимизировать вычисляемую производительность для суперкомпьютеров, но сопоставимость с x86 облегчит работу HPC-программистов, привычных к Intel Xeon.

Карты Intel Xeon Phi

Со слов создателей, для эмуляции аппаратных перспектив GPU на 62-ядерном картинном микропроцессоре Larrabee запускали ОС FreeBSD и платформу DirectXGfx. Заключительная не только лишь позволяла играть в DirectX 11-игры (конечно, на стандартной Windows-системе), но также и дополнять Larrabee свежие возможности. Пока, такой подход не разрешил Larrabee демонстрировать конкурентную мощность по сравнению с AMD Radeon и Nvidiа GeForce, что и стало причиной отказа Intel от производства Larrabee в роли GPU. Все-таки, архитектура Larrabee была применена для сопроцессоров, но затем и микропроцессоров Xeon Phi, призванных соперничать с ускорителями Nvidiа Тесла. Смотря на предельную мощность лучших Xeon Phi 7290 (3,5 FP64 TFLOPS) и Nvidiа Тесла P100 (4 – 4,6 FP64 TFLOPS для PCIe карты, 4,7 – 5,3 FP64 TFLOPS для NVLink ускорителя), достаточно логично, что нынешний Xeon Phi на основе x86 не в состоянии сопротивляться GPU на базе ядер с современной проприетарной архитектурой. Можно резюмировать, что на данный момент Larrabee не далеко пошел ни в какой из собственных первичных задач: он не стал мгновенным GPU и вряд ли может соперничать с Nvidiа на рынке суперкомпьютеров.

HD и Iris Graphics: скверный утёнок преобразуется в лебедя

Larrabee был не одним графическим планом Intel, стартовавшим в начале 2000-х годов. Как нетрудно вспомнить, ОС и графические внешние виды оказывались всё не менее взыскательными к источникам GPU с возникновением Эпл Mac OS X (2000), Microsoft Виста (2006), Эпл Айфон OS (2007) и прочих. В какой-нибудь момент Intel не сумела убедить Эпл применять её микросхемы в собственных мобильных приборах из-за того, что у компании не было сколько-то производительных интегрированных GPU. Также, Стив Джобс (Steve Jobs) убедительно требовал от Пола Отеллини (Paul Otellini, директор Intel c 2005 по 2013 год) повысить мощность встроенных графических микропроцессоров (iGPU), так как применение разрывных GPU оказывалось всё не менее проблематическим в мобильных ПК.

Проигрыш многомиллионного договора, и напористые условия значительного партнёра сделали своё дело: в 2007 году г-н Отеллини сообщил о проектах повысить мощность интегрированных GPU в 10 раз к 2010 году. Как раз тогда наступил золотой час компании Тома Пиаццы, прежде создавшей Intel 740.

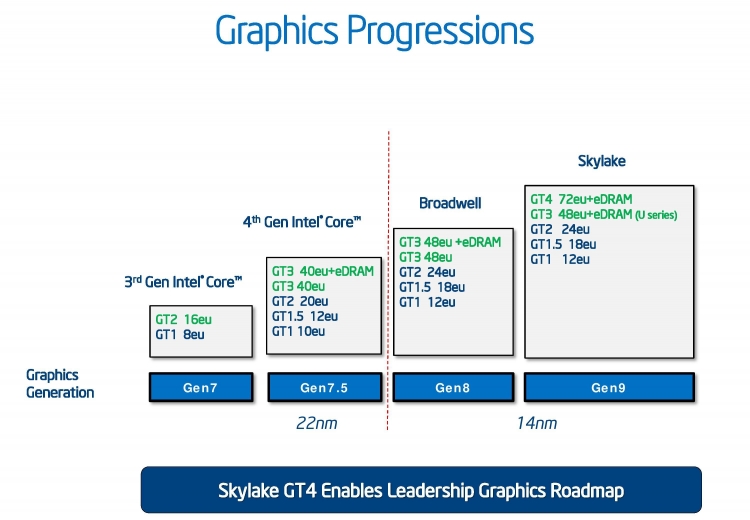

Прогресс в формировании iGPU Intel в последнее время

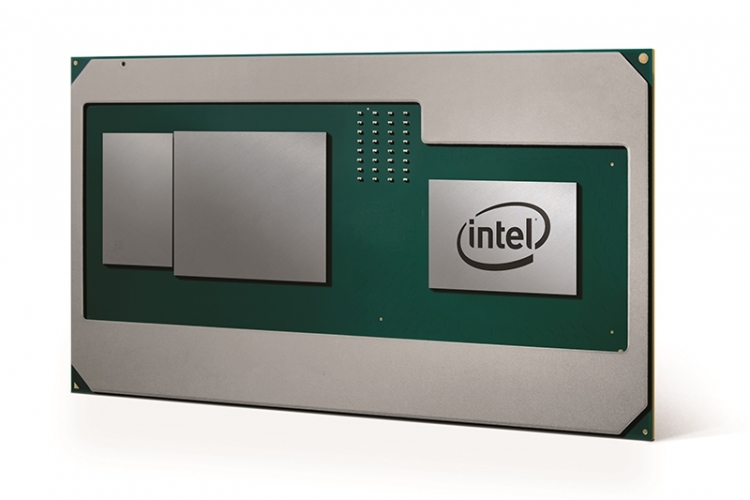

Получив оплачивание, транзисторный расчет, необходимое место на кристалле, а потом и ведущие технологии изготовления (из-за движения iGPU в микропроцессор), бригада сумела спроектировать графическое решение, которое опережало мощность iGPU примера 2007 года в 25 раз. В дальнейшие годы мощность встроенных графических микропроцессоров Intel вырастала не только лишь благодаря улучшениям в сфере архитектуры, но также и возникновению не менее производительных модификаций этих iGPU c множеством аккуратных механизмов (EU, execution units). Так, если наиболее производительное графическое ядро класса ДжиТи3 в микропроцессоре поколения Haswell владело 40 EU, то CPU поколения Skylake могут похвастать iGPU класса ДжиТи4 с 72 EU. Как продемонстрировала практика партнёрства Intel c AMD в сфере интеграции разрывного Radeon в 1 каркас с микропроцессором Kaby Lake, Intel готова идти ещё далее, чтобы представить собственным пользователям отличную мощность.

Intel Core с графикой AMD Radeon

Султан Кодури в Intel: чего ждать?

Установление на работу главного работника соперника, с которым только-только был заключен договор на поставку значительного компонента, говорит о том, как эксперт значения г-на Кодури нужен Intel.

Как хорошо видно, в отличии от начала 2000-х годов, в Intel не менее не полагают графические ускорители уделом приверженцев игр и развлечений. Мгновенная эволюция iGPU компании заключительных лет доказывает это. По всей видимости, Intel готова вкладывать в графические микропроцессоры, поэтому Султан Кодури обретет все нужные ему источники. Сам факт принятия на работу эксперта такого значения говорит об весьма серьёзных намерениях.

Интересно, что в Intel рассказывают об унификации архитектур и умной собственности на фоне того, что Xeon Phi на основе x86 не в состоянии соперничать с Nvidiа Тесла в том, что же касается мощности. Неясно, обозначает ли фраза Intel об унификации, что организация рассчитывает отказаться от x86-ядер в заключениях для суперкомпьютеров, но вряд ли это стало бы поразительным формированием происшествий.

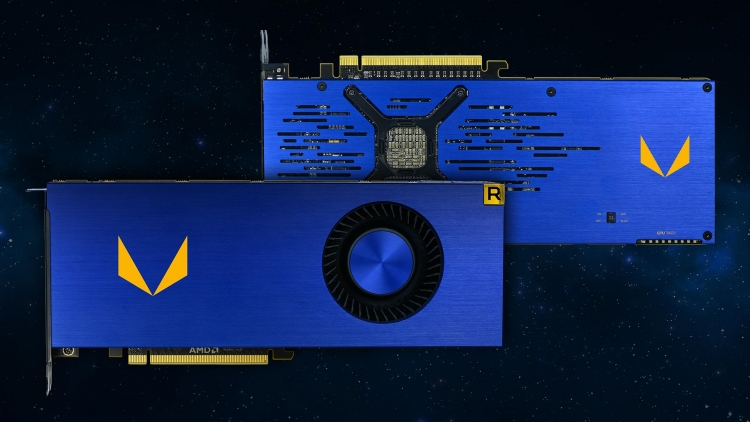

AMD Radeon Vega Frontier Edition

Наверное, самый основной вопрос, на который пока нет решения, это то, когда Intel рассчитывает выпустить собственный свежий разрывный GPU. В случае, если у компании нет готовой архитектуры, способной масштабироваться от незначительного iGPU для компьютера до разрывного графического микропроцессора объемом 550 миллиметров2 и не менее, то работа над разрывным GPU Intel будет требовать пары лет. Так что, вряд ли мы увидим плоды работы Раджи Кодури раньше 2022 года. В случае если нынешняя (Gen 9.5) либо грядущая (Gen 10, Gen 11) графическая архитектура Intel (чья разработка окончена) может масштабироваться и демонстрировать мощность сопоставимую с будущими заключениями AMD и Nvidiа, мы вполне можем рассчитывать заметить разрывный GPU компании в 2019–2020 году (не прежде, по-другому в партнёрстве Intel c AMD не было бы резона).

Не стоит забывать, что так как в изображении рабочих задач г-на Кодури числится не только лишь конструирование нового GPU, но также и стандартизация разных архитектур и умной собственности Intel, весьма возможно, что мы увидим несколько поколений продукции для различных дополнений, до того как установленная Intel цель будет сделана.

Август 16th, 2023

Август 16th, 2023  raven000

raven000  Опубликовано в рубрике

Опубликовано в рубрике